Desafíos éticos que plantea la IA generativa: “el gran bonete”

La irrupción de la IA generativa conlleva importantes desafíos éticos y sociales que deben ser abordados con responsabilidad al menos 3 de ellos son :

1. Privacidad y protección de datos:

El entrenamiento de modelos de IA generativa requiere grandes volúmenes de datos y suele ocurrir la utilización de información personal sin consentimiento, ignorar los derechos de autor de diversas obras y exposición de datos sensibles.

La generación automática de contenido (texto, imágenes, música, etc.) está desafiando los derechos de autor y la propiedad intelectual, lo que genera incertidumbre sobre la autoría y el uso legal de dichas creaciones.

2.Sesgo y discriminación:

La IA puede perpetuar o amplificar sesgos debido a los datos de entrenamiento, que a menudo reflejan desigualdades sociales. Esto puede llevar a resultados discriminatorios con serias implicaciones.

Si los algoritmos de IA de selección de personal se entrenan con datos sesgados, replicarán y reforzarán preferencias injustas, excluyendo sistemáticamente a candidatos cualificados y limitando la diversidad. Las empresas perpetuarían sesgos sin intención. Esto va a pasr en el futuro sino que ya ocurrió hace 10 años.

Amazon desarrolló en 2014 un sistema de inteligencia artificial para automatizar la revisión de currículos y seleccionar candidatos de manera supuestamente objetiva. Sin embargo, al poco tiempo, el equipo descubrió que el algoritmo penalizaba sistemáticamente los currículos que contenían la palabra “mujeres” (por ejemplo, “club de ajedrez femenino”) y rebajaba la calificación de graduadas de universidades exclusivamente femeninas.

La IA generativa puede reforzar estereotipos si sus datos de entrenamiento son sesgados.

Los sesgos algorítmicos pueden llevar a burbujas de filtro y cámaras de eco, limitando la exposición a diversas perspectivas y amplificando la desinformación.

3. Transparencia y explicabilidad:

Muchas veces, los procesos de toma de decisiones de la IA son opacos, dificultando la comprensión y la rendición de cuentas ante errores o daños causados por sus resultados. Yuval Noah Harari se refiere a esto como la “caja negra” que hace que más que “artificial” deba caracterizarse como “ajena”

Es preocupante la facilidad con la que se puede crear contenido falso o manipulado, lo que incrementa exponencialmente el riesgo de desinformación, fraude y manipulación de la opinión pública porque la línea entre la realidad y la ficción se pone borrosa.

Los "deepfakes", videos, audios o imágenes generados por IA que simulan la apariencia y voz de personas reales, son un claro ejemplo de esta amenaza.

La capacidad de producir contenido tan convincente dificulta cada vez más distinguir lo auténtico de lo fabricado, lo que puede tener graves consecuencias en diversos ámbitos:

- Política: La manipulación de discursos o la creación de situaciones inexistentes pueden influir en elecciones o generar conflictos sociales.

- Seguridad: Los deepfakes pueden ser utilizados para suplantar identidades, extorsionar o dañar la reputación de individuos.

- Economía: La difusión de noticias falsas sobre empresas o mercados puede provocar pánico financiero o pérdidas económicas significativas.

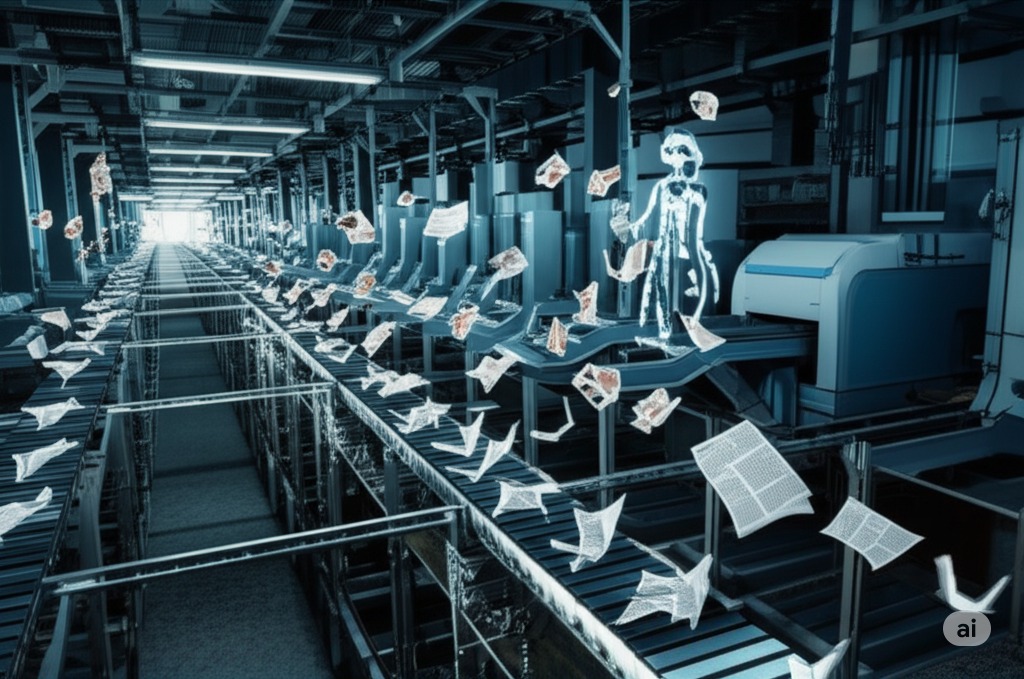

Más allá de los deepfakes, la IA Generativa también facilita la creación y difusión masiva de "noticias falsas", que se propagan rápidamente por las redes, van erosionando la confianza en los medios de comunicación y en las instituciones.

Pero a la vez más cristalizando la desconfianza y el descreimiento ante todo lo que se le presenta lo que se traduce en una indiferencia generalizada.

Estos tres aspectos ya han sido tratados extensivamente, sin embargo hay otro que no ha sido suficientemente retratado: la dilución de la responsabilidad y rendición de cuentas en la IA generativa, lo que más gráficamente se conoce como

El efecto “gran bonete”

En referencia al juego infantil donde nadie asume la culpa y todos se la pasan a otro., en el contexto de la IA se traduce en una cadena de evasión de responsabilidades entre desarrolladores, empresas, usuarios y otras partes implicadas.

Evasión colectiva de responsabilidad:

Cuando una tecnología como la IA generativa produce un daño o un resultado inesperado, suele ser difícil identificar un responsable claro. Cada actor (desarrollador, empresa, usuario, proveedor de datos) tiende a señalar a otro, diluyendo la responsabilidad individual y colectiva.

Falta de mecanismos claros de rendición de cuentas:

La ausencia de marcos regulatorios y contractuales robustos facilita que las organizaciones y los individuos involucrados en el ciclo de vida de la IA eviten asumir consecuencias por los efectos negativos de sus sistemas.

Despersonalización de las decisiones:

No se trata de Hal 9000 o entidades de voluntad propia. Al atribuir las decisiones a "la IA" o "el algoritmo", (la “caja negra” que argumenta Harari) se pierde de vista que detrás de cada sistema hay decisiones humanas fundamentales, tomadas en el diseño, entrenamiento y despliegue del modelo.

La dispersión de responsabilidades es un problema con los modelos generativos, donde errores o sesgos en los resultados (por ejemplo, contenido discriminatorio) dificultan asignar el error a desarrolladores, datos o usuarios, evitando que alguien asuma la culpa.

Las empresas u organizaciones pueden caer en la tentación de "pasar el bonete" y no implementar controles o mecanismos efectivos para prevenir daños.

La falta de responsables claros puede erosionar la confianza del público en la IA y en las instituciones que la desarrollan o implementan.

Las víctimas de daños causados por IA generativa (deepfakes) pueden enfrentar obstáculos para obtener justicia o compensación, al no poder identificar a un responsable directo.

La IA generativa introduce desafíos sin precedentes en la asignación de responsabilidades.

Para superar el efecto de "el gran bonete", son necesarios tanto marcos legales claros como una ética compartida que fomente la rendición de cuentas en todas las etapas del desarrollo y uso de esta tecnología.

Fuentes:

- El algoritmo de Amazon al que no le gustan las mujeres; https://www.bbc.com/mundo/noticias-45823470

- El debate sobre la responsabilidad de los desarrolladores de IA generativa: ¿quién es responsable en caso de consecuencias no deseadas? https://itdconsulting.com/noticias/el-debate-sobre-la-responsabilidad-de-los-desarrolladores-de-ia-generativa-quien-es-responsable-en-caso-de-consecuencias-no-deseadas/.noviembre 8, 2023

- La importancia de la rendición de cuentas de los agentes de IA; https://vizologi.com/es/importance-of-ai-agents-accountability/